티스토리 뷰

1. Support Vector Machines

- 퍼셉트론의 한계 : 결정 경계가 항상 선형이어야 하므로 범용 함수 근사기가 될 수 없음

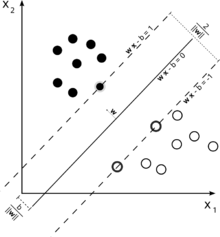

- SVM? 선형으로 분리 가능할 수도 있는 고차원으로 효율적 매핑하는 커널을 사용해 퍼셉트론의 한계를 극복

- SVM은 결정 경계로부터 가장 가까운 인스턴스의 마진을 최대화한다.

- 특징을 더 고차원으로 매핑하는 방법이 SVM임.

- 고차원 공간에 매핑 된 데이터를 학습할 때 발생하는 계산 양 문제와 일반화 문제를 SVM이 어떻게 완화시켰는지 알아보기

- SVM을 훈련시키기 위해 사용하는 최적 알고리즘을 설명하려면 고차원의 수학을 사용해야 한다.

2. SVM의 장단점

<장점>

- 실제로 그 문제들이 이진분류에 적합하지 않더라도,

- 회귀, 분류, 비정상 탐지(anomaly detection)같은 지도 문제(supervised problems)를 대다수 처리할 수 있다.

- 노이즈데이터와 이상치를 처리할 수 있는 좋은 방법이며, 서포트 벡터들만 고려하기 때문에 과적합이 덜 발생하는 경향을 보임

<단점>

- 실제로 그 문제들이 이진분류에 적합하지 않더라도,

- 회귀, 분류, 비정상 탐지(anomaly detection)같은 지도 문제(supervised problems)를 대다수 처리할 수 있다.

- 노이즈데이터와 이상치를 처리할 수 있는 좋은 방법이며, 서포트 벡터들만 고려하기 때문에 과적합이 덜 발생하는 경향을 보임

Support Vector Machines 하이퍼파라미터

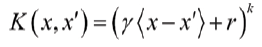

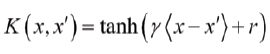

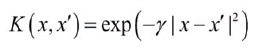

3. 커널

- 다항, 시그모이드, 가우시안, 선형 커널 등 보편적으로 사용되는 몇가지 커널을 사용한다.

- 이상적으로 커널은 과제에 유용한 방법으로 인스턴스 간의 유사성을 측정해준다.

- 커널은 SVM에서 널리 이용되지만, 로지스틱 회귀분석, 퍼셉트론, 주성분 분석(PCA, Prinicipal Component Analysis) 등 두 특징 벡터의 내적으로 표현될 수 있는 모든 모델에 사용할 수 있다

|

Polynomial kernels |

|

|

sigmoid kernel |

|

|

Gaussian kernel |

|

'인공지능 > 머신러닝' 카테고리의 다른 글

| 그래프 이론 (1) | 2019.10.16 |

|---|---|

| [ML Algorithm] 머신러닝(Machine Learning) 기본 이론 (0) | 2019.10.16 |

| 머신러닝 알고리즘 - XGBoost(eXtreme Gradient Boosting) (1) | 2019.10.15 |

| [ML Algorithm] Gradient Boosting Machine (0) | 2019.10.15 |

| [ML Algorithm] 랜덤포레스트(Random Forest) (1) | 2019.10.15 |

댓글